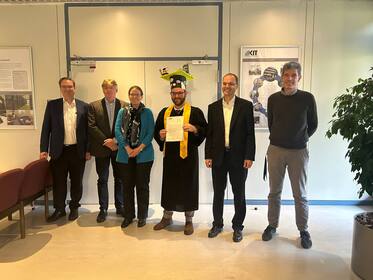

Am 31.10.2024 hat Herr Daniel Coquelin seine Dissertation erfolgreich abgeschlossen. Sein Forschungsschwerpunkt lag in den letzten Jahren auf dem verteilten maschinellen Lernen.

Herr Daniel Coquelin hat während seiner Promotion wertvolle Beiträge zum verteilten maschinellen Lernen geleistet, insbesondere auf dem Gebiet der datenparallelen neuronalen Netze. Seine frühen Arbeiten am SCC konzentrierten sich auf kommunikationsvermeidende Ansätze zum datenparallelen Training. Anschließend untersuchte er das Verhalten neuronaler Netze während des Trainings und stellte fest, dass die orthogonale Basis von Gewichtsmatrizen dazu neigt, sich während des Trainings zu stabilisieren. Auf der Grundlage dieser Erkenntnis entwickelte er eine neuartige Methode für das Training neuronaler Netze mit niedrigem Rang auf Systemen mit verteiltem Speicher. Diese Methode ermöglicht eine effiziente Skalierung des Trainings über mehrere Geräte hinweg und führt zu einer reduzierten Kommunikation, die ihre Gegenstücke mit vollem Rang übertreffen können. Seine Arbeit hat Auswirkungen auf großskalige neuronale Netzwerke wie die natürliche Sprach- und Bildverarbeitung. Die Arbeit von Herrn Coquelin wurde finanziert vom Projekt Helmholtz Analytics Framework (HAF) und der Plattform Helmholtz Artificial Intelligence Cooperation Unit (Helmholtz AI).

Das SCC gratuliert Herrn Coquelin sehr herzlich zur erfolgreich abgeschlossenen Promotion und wünscht ihm alles Gute für die weitere berufliche Laufbahn.

Dissertation von Daniel Coquelin: Optimization of AI Methods on Distributed-Memory Computing Architectures

[1] Prof. Ina Schäfer (KIT, Vorsitzende Prüfungsausschuss), Prof. Achim Streit (KIT, Erstbetreuer), Prof. Håkan Grahn (Blekinge Tekniska Högskola (BTH), Schweden, externer Prüfer/Opponent), Prof. Ralf Reussner (KIT, Prüfer), Prof. Thorsten Strufe (KIT, Prüfer)