KIT-Hochleistungsrechner HP XC3000 (hc3)

Das SCC betrieb von 2010 bis Ende Januar 2017 ein paralleles Rechnersystem HP XC3000, das aus vielen SMP-Knoten mit 64-bit Xeon Prozessoren von Intel bestand. Der Rechner erfüllte sowohl die Aufgaben eines parallelen Hochleistungsrechners als auch die Aufgaben eines seriellen, durchsatzorientierten Rechners. Der Parallelrechner konnte von allen Mitarbeiter(inne)n des KIT unentgeltlich genutzt werden.

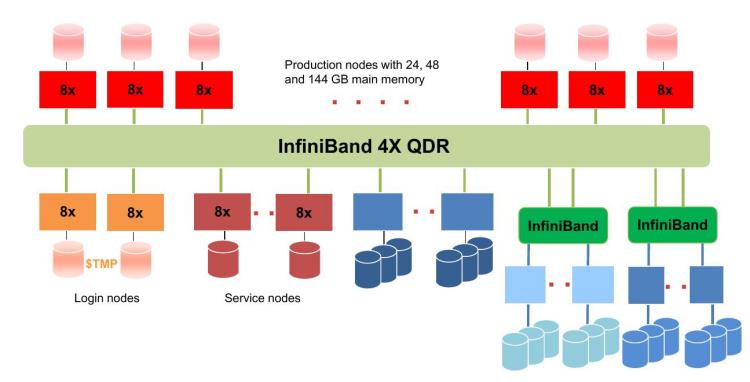

Konfiguration des HP XC3000 Systems

Der KIT-Rechner HP XC3000 beinhaltete

- 2 Login-Knoten mit jeweils 8 Cores mit einer theoretische Spitzenleistung von 81,0 GFLOPS und 48 GB Hauptspeicher pro Knoten,

- 312 Rechenknoten mit jeweils 8 Cores mit einer theoretische Spitzenleistung von 81,0 GFLOPS und 24 GB Hauptspeicher pro Knoten,

- 32 Rechenknoten mit jeweils 8 Cores mit einer theoretische Spitzenleistung von 81,0 GFLOPS und 48 GB Hauptspeicher pro Knoten,

- 12 Rechenknoten mit jeweils 8 Cores mit einer theoretische Spitzenleistung von 81,0 GFLOPS und 144 GB Hauptspeicher pro Knoten

- und als Verbindungsnetzwerk ein InfiniBand 4X QDR Interconnect mit ConnectX Dual Port QDR HCAs.

Der KIT-Rechner war ein massiv paralleler Parallelrechner mit insgesamt 366 Knoten, wobei 10 Knoten davon Service-Knoten sind. Alle Knoten - auch die Service-Knoten - hatten eine Taktfrequenz von 2,53 GHz und besassen lokalen Speicher, lokale Platten und Netzwerkadapter. Ein einzelner Rechenknoten hatte eine theoretische Spitzenleistung von 81,0 GFLOPS, so dass sich eine theoretische Spitzenleistung von 30,8 TFLOPS für das gesamte System ergab. Der Hauptspeicher über alle Rechenknoten hinweg betrug 10,8 TB. Alle Knoten waren durch ein InfiniBand 4X QDR Interconnect miteinander verbunden.

Das Basisbetriebssystem auf jedem Knoten war ein Suse Linux Enterprise (SLES) 11. Als Managementsoftware für den Cluster diente KITE; KITE ist eine offene Umgebung für den Betrieb heterogener Rechencluster.

Als globales Dateisystem wurde das skalierbare, parallele Dateisystem Lustre über ein separates InfiniBand Netzwerk angebunden. Durch die Nutzung mehrerer Lustre Object Storage Target (OST) Server und Meta Data Server (MDS) wurde sowohl eine hohe Skalierbarkeit als auch eine Redundanz beim Ausfall einzelner Server erreicht. Im HOME-Verzeichnis, das das gleiche ist wie das HOME-Verzeichnis des InstitusClusterII, stehen ca. 469 TB an Plattenplatz zur Verfügung. Im WORK-Verzeichnis standen ca. 224 TB an Plattenplatz zur Verfügung. Daneben war jeder Knoten des Clusters mit lokalen Platten für temporäre Daten ausgestattet.

Detaillierte Kurzbeschreibung der Knoten und des Verbindungsnetzwerks:

10 Service-Knoten Proliant DL170h mit 2 acht-Wege (Login-)Knoten mit jeweils 2 Quad-Core Intel Xeon E5540 mit einer Taktfrequenz von 2,53 GHz, 48 GB Hauptspeicher und 6 146 GB großen lokalen SAS-Platten, 2 acht-Wege (Head-)Knoten mit jeweils 2 Quad-Core Intel Xeon E5540 mit einer Taktfrequenz von 2,53 GHz, 24 GB Hauptspeicher und 6 300 GB großen lokalen SAS-Platten, 2 acht-Wege (NAT-)Knoten mit jeweils 2 Quad-Core Intel Xeon E5540 mit einer Taktfrequenz von 2,53 GHz, 24 GB Hauptspeicher und 2 250 GB großen lokalen SATA-Platten und 4 acht-Wege ("Resource Management"-)Knoten mit jeweils 2 Quad-Core Intel Xeon E5540 mit einer Taktfrequenz von 2,53 GHz, 24 GB Hauptspeicher und 2 250 GB großen lokalen SATA-Platten;

312 8-Wege (Rechen-)Knoten mit jeweils 2 Quad-Core Intel Xeon E5540 mit einer Taktfrequenz von 2,53 GHz, 24 GB Hauptspeicher und einer 250 GB großen lokalen SATA-Platte;

32 8-Wege (Rechen)-Knoten mit jeweils 2 Quad-Core Intel Xeon E5540 mit einer Taktfrequenz von 2,53 GHz, 48 GB Hauptspeicher und einer 250 GB großen lokalen SATA-Platte;

12 8-Wege (Rechen)-Knoten mit jeweils 2 Quad-Core Intel Xeon E5540 mit einer Taktfrequenz von 2,53 GHz, 144 GB Hauptspeicher und 8 146 GB großen lokalen SAS-Platten.

Ein einzelner Quad-Core Prozessor hatte 4x256 KB L2-Cache und 8 MB "shared" L3-Cache, bot einen Durchsatz von 5,86 GT/s über die QPI-Links, wobei die Speichermodule mit einer Frequenz von 1333 MHz direkt angebunden waren.

Als Verbindungsnetzwerk diente ein InfiniBand 4X QDR Switch (2x324 Ports) von Voltaire mit einer Gesamtdurchsatzrate von 342 x 40 Gb/s = 13,7 Tb/s. Als Adapter wurden ConnectX IB HCAs (Dual Port QDR, PCIe2.0x8 mit 5GT/s) eingesetzt.

Zugriff auf die HP XC3000

Nur sichere Verfahren wie secure shell (ssh) und die zugehörige secure copy (scp) waren beim Einloggen bzw. beim Kopieren von Daten von und zur HP XC3000 erlaubt. Die Mechanismen telnet, rsh sowie weitere r-Kommandos waren aus Sicherheitsgründen abgeschaltet.